近期,北京通用人工智能研究院(BIGAI)机器人实验室、仿真与交互实验室联合人工智能研究院朱毅鑫助理教授团队、美国加州大学洛杉矶分校蒋陈凡夫副教授团队,在Engineering(中国工程院院刊)发表了论文“A Reconfigurable Data Glove for Reconstructing Physical and Virtual Grasps”。

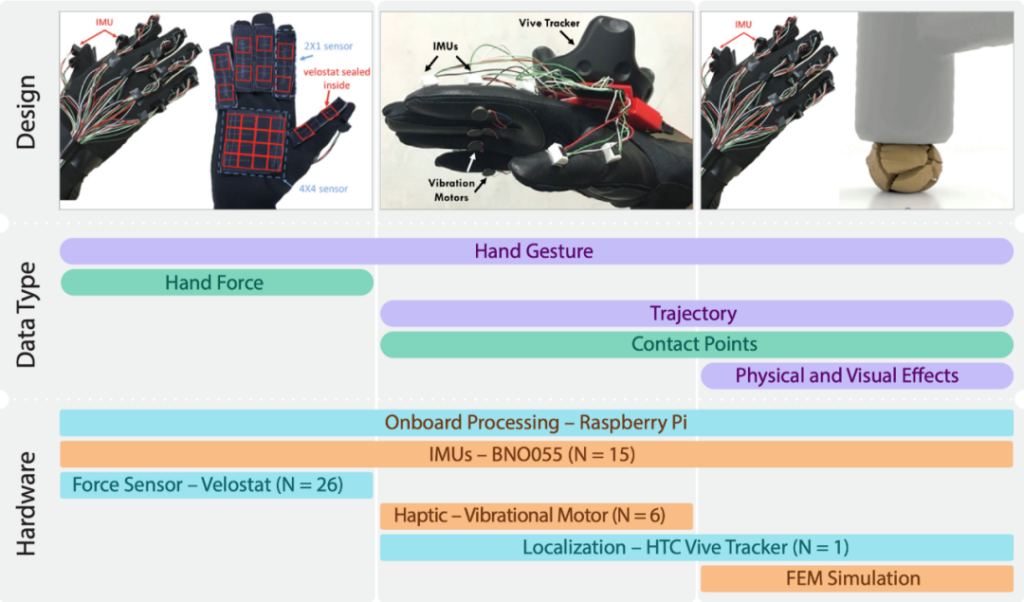

本论文提出了一个可重构的数据手套设计方案(见上图),用于捕捉人与环境互动的不同模式。该数据手套基于一套重建手势的IMU(惯性测量单元)模组,可以重构成触觉感应、虚拟现实和仿真三种模式,用以服务于不同性质的下游任务。采集的数据便于实现更高效的人机协作,并迈向更高级的通用人工智能。

本文共同一作为刘航欣(BIGAI)、张泽宇(BIGAI)、焦子元(BIGAI);通讯作者为刘航欣(BIGAI)、朱毅鑫(北京大学)。

原文链接:https://www.sciencedirect.com/science/article/pii/S2095809923000978

项目网站:https://sites.google.com/view/engr-glove

为了对论文研究进行深入的解读,通院对论文共同一作刘航欣、张泽宇研究员进行了问答访谈,以下是问答摘录。

Q1:请介绍一下该项目的研究初衷。

刘航欣:近年来,具身智能(embodied AI)领域发展迅猛。构建的具身智能体(embodied agents)可以在仿真环境中完成导航、物体抓取等基本任务。然而,学习更为复杂的操作和交互技能(Fine Manipulation)仍然是具身智能领域最具挑战的课题之一。同时,智能体在仿真环境中习得的技能往往在现实环境中应用受限,这主要是因为仿真环境中的数据与现实环境存在较大差距(sim2real gap)。

Q2:那么该如何解决这一差距呢?

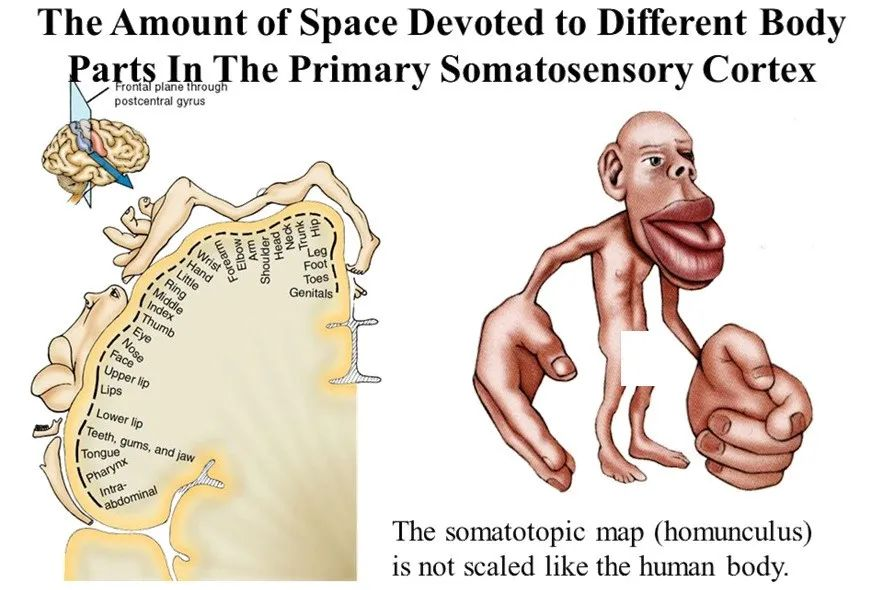

刘航欣:可以借鉴我们人类自身,我们非常擅长操纵物体并与环境进行交互,这是因为人手具有很高的灵巧性以及丰富的感知能力。下图展示了一种基于大脑皮层中与各个身体部位对应的运动和体感功能区域大小绘制的人体卡通图(图一:皮质小人cortical homunculus)。与在人体中占据的实际大小相比,手部在大脑功能区域中的占比远远大于其他体感部位。因此要让具身智能体学习复杂的操作技能,关键在于捕捉和理解人手在操作过程中涉及的交互过程和细粒度的物理变化。

图1:Riedl R, Léger P M. Fundamentals of neuroIS., Studies in neuroscience, psychology and behavioral economics, 2016

刘航欣(接上):为此,我们(BIGAI机器人实验室、仿真与交互实验室)联合北大/UCLA团队自2017年以来在这一领域的研究取得了一些进展和成果,团队通过使用数据手套(data glove)来采集人在完成操作任务时与物体的交互数据,并让机器人从中学习。

Q3: 数据手套的历史可以追溯到70年代,而伴随元宇宙的兴起,手套也几乎是VR设备里的“标配”,请问我们研究的数据手套与之相比有何差别呢?

图2:Mark Zuckerberg在测试Meta研发的VR手套(图源网络)

张泽宇:外面那些手套更多侧重于交互属性,而非用于采集和分析人手在不同任务里的表现,因此不能很好地服务于科研目的。而我们团队提出了一个可重构的数据手套设计方案(见图3),用于捕捉人与环境互动的不同模式。该数据手套基于一套重建手势的IMU(惯性测量单元)模组,可以重构成触觉感应、虚拟现实和仿真三种模式,用以服务于不同性质的下游任务。

图3:数据手套的3种模式对应的采集数据种类和关键传感器

Q4:该手套重建为三种模式分别有什么优势呢?

张泽宇:

在触觉感应模式(Tactile-sensing mode)下,该手套通过由软而薄的压阻材料制成的定制“力传感器”,采集人在操作过程中的施力情况。在不干扰手部运动的前提下,可以获得人在操作物体时手势和手部用力的耦合关系。

在虚拟现实模式(Virtual reality mode)下,我们设计了一种通过检测手和物体之间的碰撞事件来判断手套抓握是否成功的方法,在虚拟环境中记录手和物体之间的接触信息。这类信息在现实环境中通常难以获取。

在仿真模式(Simulation mode)中,我们进一步利用最新的有限元法(Finite Element Method)[1],来模拟物体在交互过程中细粒度的“四维(4D)操作数据”,包括手和物体在三维空间中的运动以及物体的物理属性(如应力、能量等)在时间维度上的变化。总而言之,通过采集到的数据,我们成功地让机器人学会了复杂的操作动作[2,3]、生成解释[4]以及工具使用[5]等高难度技能。

Q5:可以对这三个模式进行更详细的介绍吗?它们分别解决了哪些技术或应用难点?又是如何解决的?

张泽宇:好的,我分开来介绍。

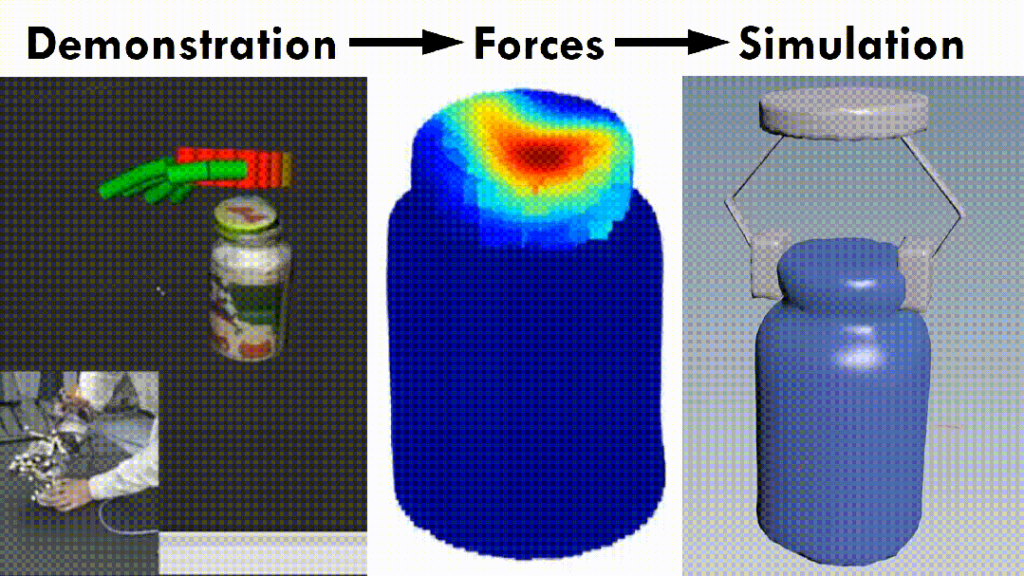

1、触觉感应模式。我举个例子来说明技术和应用难点:在国外一些药瓶通常配备了特殊设计的安全装置,用于防止儿童轻易地打开药瓶并误食药物。这些安全装置包括需要先向下按压瓶盖再转动、挤压瓶盖特定部位解锁安全装置等。然而,这些精细的操作动作在视觉图像上难以识别,因为其中关键作用的“力”无法通过视觉捕捉到。下图列举了使用触觉感应手套收集的不同类型药瓶的打开动作和对应的手势和力信息。这些示例显示了打开药瓶的动作和传统瓶子的动作之间的微小差别,同时也表明仅凭视觉信息无法充分区分各种打开瓶子的方式。

图4:使用触觉感应手套收集的不同类型药瓶的打开动作和对应的手势和力信息。

我们的解决方案:为了采集细粒度的人与物体交互的手势和力的信息,我们在2017年提出了触觉感应手套[6]。该手套通过一个IMU网络来捕捉手部的运动姿态,并在操作过程中使用六个定制的力传感器来捕捉手部施加的力,从而更全面更细致地反映人与物体交互过程。

方案优势:通过触觉感应手套所采集的数据,我们还提出了相应的机器人技能学习方法[2,3],可以有效地帮助机器人理解在解锁童锁、打开药瓶等任务中起关键作用的“力”因素,并成功地学会这一技能(见图5)。同时,“力”这一信息也为机器人的行为决策提供了很好的解释,从而增强了人对机器人的信任[4]。

图5:机器人理解在解锁童锁、打开药瓶等任务中起关键作用的“力”因素

2、虚拟现实模式

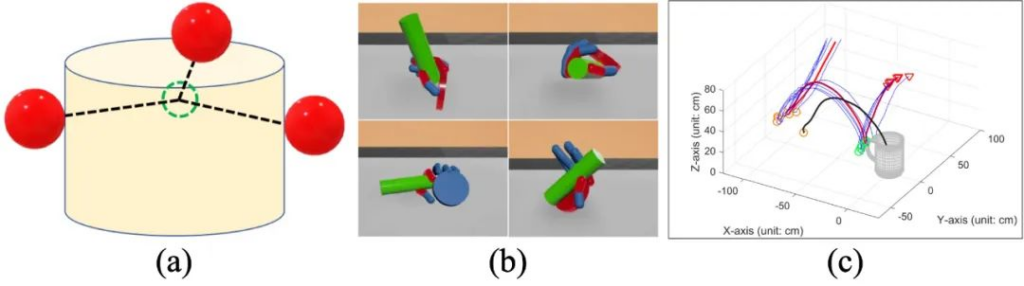

我同样举例来说明技术和应用难点:当一个人在决定如何抓取物体时,这背后其实经历了一系列复杂的感知和认知过程,包括考虑物体表面纹理、物体功能以及完成任务的需求等。为了分析抓取行为背后的认知过程,需要获取人与物体之间的接触信息(contact points)。然而,精确地采集这种数据非常困难。因为需要准确的手部和物体的三维模型、空间坐标等信息,而手在抓取过程中会发生变形,使得相应的采集变得更加困难。

我们的解决方案:为了更加便捷、灵活和大规模地获取人在抓取时与物体之间的接触信息,我们团队于2019年设计了一款虚拟现实手套,利用虚拟现实平台来获取接触信息[7]。这种设计结合了基于笼抓的方法,通过手指和物体之间的碰撞几何来确定对虚拟物体的稳定抓取,如图6所示。当所有碰撞点(红色球体)的几何中心(绿色虚线圆圈)与物体(黄色圆柱体)重叠时,就可以认为物体被稳定地抓取了。然而,由于抓取的是虚拟物体,缺乏实际接触时的物理反馈和反作用力,手很容易产生不自然的抓取动作。为了解决这一问题,我们在手套上面部署了一个震动马达网络,当手在虚拟环境中与物体接触时,相应部位的震动马达会被激活,为用户提供触觉反馈。

图6:通过手的模型与物体在VR中的接触情况,判断能否成功抓取

方案优势:我们提出的虚拟现实手套相较于现有的商用虚拟现实设备,能够更稳定地在虚拟环境中模拟稳定抓取和接触信息。如图7所示,通过我们的系统,不同用户可以在虚拟环境中与各种几何形状的日常物体进行交互,从而采集到多样化的手部姿态和接触信息。这有助于我们揭示物体外形与抓取手势之间的关系,并且可用于学习和提高机器人的抓取能力[8]

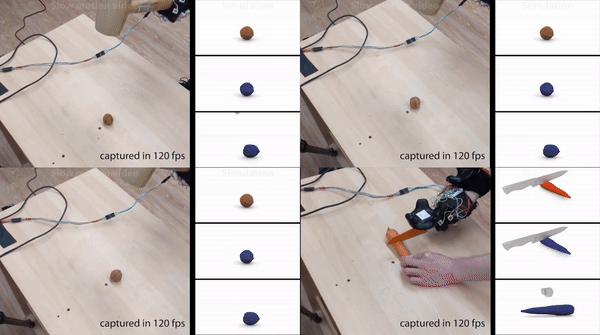

3、仿真模式

同样举例来说明技术和应用难点:尽管数据手套在人类抓取操作过程中能够提供丰富的数据,然而这些数据都是与手相关的,难以反映物体自身在操作过程中的变化,也难以体现由交互动作引起的效果。例如,在使用工具的场景中,人的手挥动锤子砸向核桃,尽管锤子、抓取姿态和运动轨迹相似,但可能导致不同的结果,比如核桃未砸开、砸开或砸得粉碎。要全面地理解这个操作工具的过程,需要将手、工具和动作效果三者放在一起考虑。值得注意的是,无论是物理传感器还是视觉识别方法,都无法对这种复杂状态变化进行追踪。

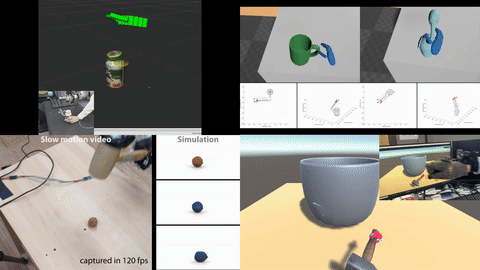

我们的解决方案:为了描述物体状态变化的细节过程,我们采用了最先进的有限元方法 [1],基于物理学原理来模拟物体随时间变化的状态(流态 fluent),以及其中涉及的物理属性,如接触力和物体内部的应力。在仿真模式下,我们的手套实现了在4D空间中进行操作任务的分析:(1)在3D空间中获取手势和物体的接触信息和几何信息;(2)追踪物体状态在时间维度上的连续变化。如图六所示,根据手套采集的数据,我们可以在物理仿真环境中重现细粒度的场景,并获取交互过程中物理属性的变化信息。这种提供人与环境交互事件整体视图的4D数据是该领域的首创,将为研究物体操纵和抓取开辟新的研究途径。

图7:在仿真中,基于人的活动数据,计算出物体(核桃、萝卜)的状态变化过程和相对应的物理量(如受力情况)

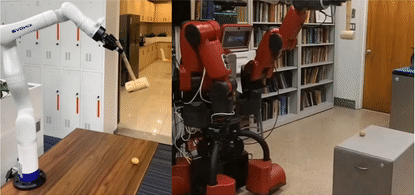

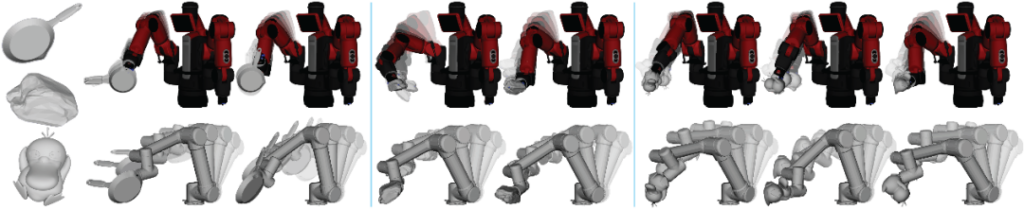

方案优势:通过对人与环境交互事件整体4D数据的理解,智能体能够发掘交互过程中的核心物理特性,从而习得动作与其效果之间的因果规律。我们最近的研究表明,机器人可以利用采集的4D交互数据,学会以最省力的方式将任意物体当作工具使用,而无需生硬地模仿人的动作轨迹[5](见图8)这一研究成果为研究物体操纵和抓取开辟了新的途径,为智能体在实际操作中更加灵活、高效地与环境进行交互提供了有力的支持。

图8:身体结构不同的机器人,都能找到一个对其最高效的工具使用方法。

Q6:我们的手套技术还有哪些应用价值和发展空间?

刘航欣:实现“小数据”的人工智能范式对数据的质量提出了更高的要求:这些数据不能仅仅是一项常见的文本和图像,而是要能够揭示体现任务本质的可供性、因果性和功能性等。为此,我们提出了基于统一骨干设计的手套系统,可以在触觉感应模式、虚拟现实模式和仿真模式下,有效地采集不同任务和不同类型数据(如力、接触点和物体物理状态变化),从而促进智能体对复杂操作任务的学习。同时,这个手套系统也为通讯式学习(Communicative Learning)框架[9]提供了更丰富的数据类型和更自然的人机交互方式,使得计算模型能够更全面地理解人类的价值观和感受人类的操作技巧,从而实现更高效的人机协作,并迈向更高级的通用人工智能。