7月29日,ACM中国图灵大会在武汉隆重召开,本次大会由武汉大学、清华大学、北京大学、东湖高新技术开发区、北京大学武汉人工智能研究院等国内多家高校联合主办,以“通用智能,人机共生”为主题,吸引了来自全球各地的2000余位顶尖学者、专业人士和学生汇聚一堂。

当天下午,中国图灵大会SIGAI专题研讨会上,一场主题为“大模型与通用人工智能”的圆桌对话成为全场焦点。在SIGAI China论坛组委会主席、北京大学人工智能研究院认知推理中心主任王亦洲教授的主持下,多位专家学者围绕大语言模型的产学研现状、通用人工智能的发展路径等话题畅所欲言,其中避免产业界和学术界的盲目狂热与资源浪费、关注通用人工智能的本质问题、发挥多领域建设性作用等观点话题被多次提及,成为全场共识,为我国推进通用人工智能发展出谋划策。

百“模”大战:一种焦虑心态资源浪费以及舍本逐末

今年以来,以ChatGPT为代表的大语言模型受到学术界与产业界广泛关注,目前国内参与大模型的团队及其产品达到了100个以上,形成了规模超前的百“模”大战。

阿里妈妈及闲鱼首席技术官郑波博士认为,国内很多的企业或者创业机构积极投身大模型建设,一定程度反映了对中美科技差距的焦虑。

北京师范大学认知神经科学与学习国家重点实验室主任李武教授指出,发展大模型,是因为看到了它带来的一些好处,以及避免被“卡脖子”的困境。但是,目前确实存在百“模”大战、重复投入资源的现象,是一种资源浪费。从国家层面要提倡做有组织的科研、资源共享。

北京大学人工智能研究院杨耀东教授表示,从工程的角度来看,很多百“模”大战的参与者,就是把开源的模型加上自己收集的一些中文数据,然后再调试一下就出来了,但是在这过程中我们是否能沉淀出一些我们国家自己的研发技术?是值得商榷的。例如GPT里面用到Flash Attention 和Group Query Attention两个注意力算子,以国产架构去重新复现是非常困难的。如果我们不能沉淀积累自己的底层工程技术的话,即便可以实现GPT3.5的水准,赶上美国的差距还有很长的路要走。

北京通用人工智能研究院院长朱松纯教授表示,商业炒作是产生所谓百“模”大战现象的核心之一,这对正常的学术秩序造成了冲击。他表示,大模型不是通用人工智能,不满足通用人工智能的基本条件,对通用人工智能的讨论应该回归学术本身。

从学术的角度看大模型:智能的内涵不应该被低估

美国密西根大学心理学系与统计系张俊教授表示,大语言模型横空出世,是一个里程碑的事件。它本质上是对人类语言最基本部分的一种刻画,next token generation这种模式的确在人类心理学实验中得到验证。但是语言跟人的思维、推理等各种高级认知现象之间的关系,还远远没有像目前大模型所刻画的那么简单。大模型到底多少程度上是一种智能?很值得商榷。大模型的功能不能被无限的放大。要真正刻画人的智能,要从发展心理学等角度来研究和定义智能。

李武教授提到,从神经生物学的角度来看,人类的神经元非常动态灵活,同一个神经元接受同一个刺激 100 次,结果服从泊松分布,这种噪声恰恰正是它灵活的表现。目前的神经网络都比较专用,并不符合人脑的工作方式。如果拼命炒作大模型本身这件事,只关注参数从几十个亿、几百亿扩张到几千亿,不能实现真的智能。相反,如果借助CNN这些人工神经网络,与人的生物神经网络对照,通过模拟基因敲除实验、研究重要神经单元的作用,可以建立人工智能与脑科学之间相互印证、相互迭代的关系,这可能是一种独辟蹊径的发展道路。

朱松纯教授认为,大模型没有具身、价值、目的等自上而下的高级反馈调控(feedback)机制,也没有模块化的结构(architecture),本质上仍然是个统计模型。事实上,在统计模型之外还应该有因果模型、有价值体系、有认知架构,这样才能实现心智理论、自我意识等高级功能,“只有结构上实现完备性了(AI Completeness),智能才能完备,才有可能实现通用人工智能”。

LLM距离AGI还有多远:算力,数据,模型

最近一段时间,社会上经常听到将大语言模型称作通用人工智能的说法。大模型是通用人工智能吗?大模型到通用人工智能还有多少距离? 与会的专家学者提出了不一样的观点。

郑波表示,大语言模型的参数已经达到了千亿规模,需要巨大的计算资源。产业界在发展大模型时,确实会遇到算力等现实问题。这背后是我国芯片等硬件技术被卡脖子的困境。他认为,大模型确实探索了一些商用价值,但是代价很昂贵。要克服算力的现实问题,需要我国在硬件方面有所突破,以及实现人工智能架构上的突破、形成更好的发展道路。

北京通用人工智能研究院前沿研究中心联席执行主任、机器人实验室负责人刘航欣博士认为,通用人工智能必然不是某个单一维度能力的体现。它需要包括视觉、语言、认知、机器人、机器学习、多智能体等多个方面。现在训练GPT已然要穷尽了地球上所有的计算资源、文字与图片资源。然而,未来人工智能的发展必然要有不同领域、不同模态、不同应用场景的结合,当智能体进入三维真实环境,问题复杂度会大幅提高,对大模型的数据、算力和模型架构都提出了挑战。仅靠大模型难以完成数据与模型表达的挑战,我们需要有一套统一的理论架构去实现视觉、语言、认知、学习、执行等能力。

张俊谈到,在小孩子的发展过程中,语言起了很大的作用,语言对整个认知发展起的作用是交互的,比如小孩怎么通过与环境的互动建立新的认知模型。大语言模型把语言在整个通用人工智能之中所起的作用刻画出来了。因此,现在是一个很好的时机,把语言模型跟具身认知模型结合起来,可能是一条通用人工智能的道路。

人工智能安全:扬汤止沸 vs. 治标治本

在人类朝着通用人工智能一路飞驰的道路上,也有人提出了担忧与警惕。今年6月,联合国秘书长提出支持建立类似国际原子能机构(IAEA)的全球性AI监管机构。

杨耀东提到,GPT本身使用的next token generation技术,从本质上决定了其安全风险无法避免。给它喂什么样的语料,它就能说出什么样的答案。目前很多语料数据都没有被审查过,里面有很多知识本身都是不准确的,为了让其更安全,就需要实现带有安全约束的、价值对齐的模型。目前大多数的解决方案还是以数据驱动为主,并没有一个治根的方法。

朱松纯认为,通过限制机器人的行为来保证AI安全,好比“捂住嘴”、围“栅栏”、设置“禁行区”,这无异于“扬汤止沸”,其实是一种“治标不治本”的做法,不能根本上解决问题。那如何治本?智能体的行为是由价值观决定的,价值观对了才不会做伤害人的事情。因此,一个安全的系统必须以价值驱动、在价值空间与人类对齐,而不是仅仅限制住它的行为空间。他认为,尽管以统计方法为代表的人工智能算法在过去三十年取得了很大的进展,但是新的阶段需要新的赛道,人工智能未来的发展方向是“为机器立心”,要以“心”(价值)来驱动智能体的行为。只有价值体系、认知架构这些核心的模块建立起来,才能实现通用人工智能,实现人机和谐共生。

各位嘉宾的圆桌讨论在现场引起了热烈反响。

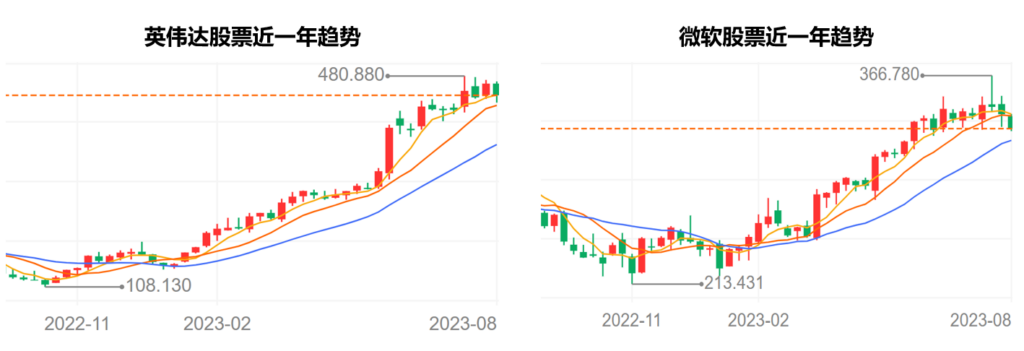

有参会观众表示,自ChatGPT发布和百“模”大战以来,英伟达、微软以及国内一些大厂的股价疯狂上涨,造成我国AI领域科研和产业成本大幅提高。这背后,国内对大模型的资本炒作与过量建设是重要原因。互联网资本由于缺少新的业务增长点,不得不在大模型这唯一的亮点上“卷”起来,甚至之前从事比特币的厂商,也在趁着“大模型”热度疯狂出售“挖矿”剩下的“矿卡”。

多位与会学者提到,最近知乎上有个很火的问题:“如何看待将大语言模型混淆为通用人工智能”,部分从业者浑水摸鱼,用“大模型”作为新的炒作概念,比如把用了多任务的模型就宣称为“大模型”,用了transformer结构的就叫“大模型”,把视觉的SAM也称为视觉大模型,很多机构把自己原本和人工智能关系十分疏远的业务强行套上“通用人工智能”的概念。

有研究者批评道,自媒体和部分媒体没有经过论证,将大模型说成是“通用人工智能”,或者是通向通用人工智能的唯一路径,不断暗示“大模型”将在未来很短的时间内获得人类的能力,在此过程中本来应该予以辟谣的学术界人士,有的为了自身利益大为鼓吹,更有甚者亲自下场和资本组局。

还有业界人士指出,科学、技术、产品是三个层次的东西,在科学和技术都有所欠缺的情况下,单独在产品层面进行过量资源的内卷,没有太大的意义。“百模大战”是之前已经发生过的互联网和资本大战的延续,之前发生了“直播大战”、“团购大战”、“视频大战”和“元宇宙大战”,这些“大战”的时间越来越短,结局越来越虎头蛇尾,浪费的社会资源越来越多,科学技术和产品服务却没有本质上的发展和进步。

大家纷纷表示,这次围绕大模型与通用人工智能的圆桌论坛发出了不一样的声音,能够从专业的角度为大模型的“过热”降温、为通用人工智能长远发展的“杂音”去噪。

本次SIGAI研讨会大咖云集,百余位国内外学术界和产业界的知名专家学者展开多领域跨界主题对话、发布研究成果,为通用人工智能的未来发展凝聚共识、校准方向。