具身智能研究的不断发展对智能体训练环境的复杂度、丰富度、交互性都提出了更高的要求。传统场景生成方法更多将重点放在了场景的外观上,这种“外观导向”的场景设计思路,常常忽略了智能体训练的两大关键——物理合理性和交互性。

北京通用人工智能研究院(简称“通研院”)创新提出了一种专门用于“生成物理可交互3D场景”的新方法PhyScene,其生成场景包括铰链物体的物理环境,为具身智能提供多种物理交互,从算法创新和模拟应用上实现了对传统智能体训练场景搭建的显著优化。

研究结果表明,PhyScene生成的场景在解决现实世界扫描数据受限、数据集内物体不交互、训练集场景违背物理仿真约束现象等关键问题上表现尤为突出,为连接场景生成和具身智能两大任务的新研究课题铺平了道路,能够促进具身智能研究进一步发展。

该成果论文《PHYSCENE: Physically Interactable 3D Scene Synthesis for Embodied AI》因其创新性获得CVPR2024会议Highlight。论文的共同一作为通研院杨燕丹、贾宝雄,合作者为通研院智佩渊和黄思远。

论文地址:

https://arxiv.org/pdf/2404.09465

项目demo地址:https://physcene.github.io/

代码地址:https://github.com/PhyScene/PhyScene/tree/main

图 1 PhyScene为智能体生成可交互场景

研究背景

场景生成在计算机视觉领域一直备受关注。最初,该任务主要是为了改进室内设计应用,致力于创建具有真实、自然特征的多样化 3D 环境。随着具身智能的出现,这项任务的目标有了新的维度。如今,虚拟环境能够支持大量复杂的具身任务,其中场景生成是非常重要的数据源。场景生成致力于为智能体提供无限的仿真场景,让智能体能够稳定地学习导航、操纵等技能。

然而,实现从“传统场景生成算法”到“为具身智能定制的场景生成算法”的转变,是一项极具挑战性的工作。由于具身智能任务涉及物理仿真,所以要求其生成的场景必须遵守物理约束,同时实现物体(如铰链物体或流体)和场景布局(如物体的可达性)之间的高度交互性,才能帮助智能体在场景中学习技能。要完成这种转变,困难具体来自以下两方面:

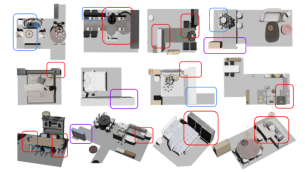

首先是数据受限的难题。以前的场景数据主要来自于人工设计的场景,然而这些数据集中的物体不可交互,且忽略了物理约束(如下图)。在这种数据集上,要实现训练符合物理交互要求的场景生成模型是极具挑战性的。

图 2 训练集场景中违背的物理仿真约束的示例。红色(物体之间穿模)、紫色(物体超出房间外)和蓝色框(智能体无法到达区域)

其次,对物理交互性进行建模也是难点。例如,如何让场景拥有足够的工作空间,确保物体的可达性和交互性。将这些抽象概念的设计建模融入神经网络并进行训练和优化,也是研究团队工作中必须要跨越的障碍。

算法创新

为此,研究团队提出了PhyScene,一种嵌入物理可交互性的扩散模型,用于可交互的场景生成。

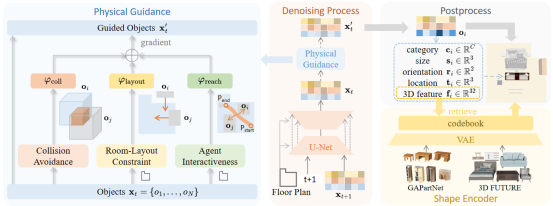

研究采用扩散模型,将平面图形状作为条件输入,并使用三个有效的物理引导模块指导扩散过程,提高物理合理性和交互性,从而生成场景。最后使用3D特征,用于跨数据集检索铰链物体和刚性物体。

图 3 PhyScene模型结构

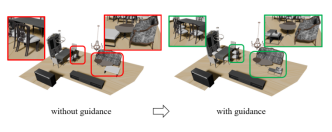

第一个物理引导模块中,为了避免直接计算网格(mesh)的碰撞,团队使用预测的边界框(bounding box)来计算3D IoU(Intersection over Union)。有了这个引导,消除了物体之间的碰撞。

图 4 避免碰撞引导前后效果对比

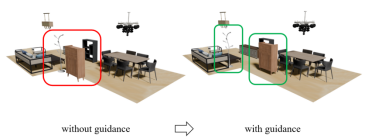

第二个物理引导模块是房间布局引导,对平面外的物体进行位置纠偏,确保每件物品都在房间内。研究团队使用类似的、在物体和墙壁之间的 IoU分数作为引导函数。在此引导下,平面图之外的物体被引导移动至平面内。

图 5 房间布局引导效果前后对比

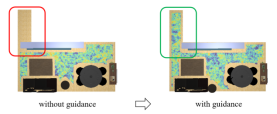

第三个物理引导模块是可达性引导。首先将生成的场景映射到2D房间蒙版,并根据机器人尺寸,计算可行走区域。然后对每个物体使用高斯分布,来形成一个代价图。利用这个代价图,研究团队在两个最大连通域的中心点之间,规划最短路径。接着选择L个机器人在这条路径上的位置作为bbox。最后计算物体和机器人之间的IoU分数。有了这个引导,障碍物被移开了,分离的区域被连通了 。

图 6 可达性引导效果前后对比

研究贡献

一、提出了一种名为PhyScene的引导扩散模型,可以生成具有真实布局和铰链物体(可交互物体)的物理可交互场景。

二、通过巧妙设计引导模块,包括避免碰撞、房间布局和智能体交互的约束转化到PhyScene模型中,以简单而有效的方式确保生成场景的物理合理性和可交互性。

三、通过与其他模型的比较,PhyScene不仅可以在传统场景生成指标上达到最优的结果,还在精心设计的物理指标上显著优于现有的场景生成算法,为连接场景生成和具身智能两大任务的新研究课题铺平了道路。

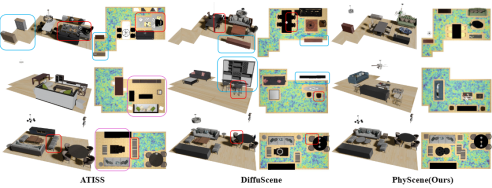

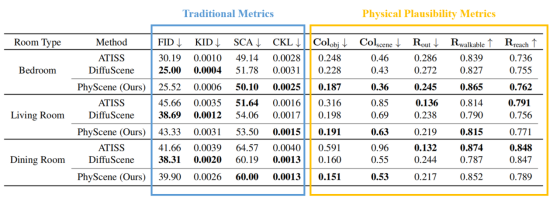

实验结果显示,团队比较了PhyScene和以前方法的场景生成结果。结果显示,PhyScene的方法显示出更好的性能。

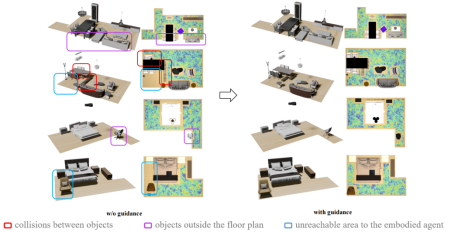

图 7 与其他方法效果对比

本研究对比传统研究中的一系列指标以及本研究提出的“物理合理性”指标。结果显示,本研究指标优于传统研究指标。

图 8 PhyScene在指标上表现优异

图 9 添加物理引导前后效果对比,添加引导显著提高了物理合理性

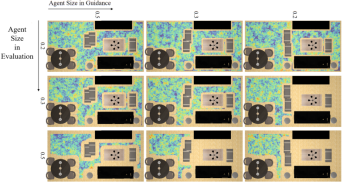

在可达性引导中,研究团队测试了不同机器人尺寸。结果显示,较小尺寸的可达性引导结果,不适合尺寸更大的机器人,机器人只能到达房间的一半;用更大尺寸的引导,可以扩大可移动区域以适应更大的机器人,并使整个房间都可以到达。

图 10 不同机器人尺寸的可达性引导结果

更进一步,为了生成具有铰链物体(可交互物体)的场景,研究采用了物体的3D特征。3D特征是通过使用3D Future和GAPart Net训练的VAE编码器获取的。其中铰链物体并没有出现在场景数据集中。以下是包含铰链物体(可交互物体)的场景。

图 11 生成的可交互场景

研究团队进一步尝试用从未使用过的地板形状,生成整个房屋。这里展示了单房间和多房间的房屋生成效果。研究团队还在英伟达的Isaac Sim里测试物理合理性。在仿真模式下,物体保持稳定,铰链物体也可以成功交互。

图 12 PhyScene生成整个房屋,并在仿真环境中测试

研究使用机器人来检查可达性,用键盘控制机器人在整个房子四处走动。团队同时对机器人做运动规划,测试与铰链物体的交互效果。

图 13 机器人与场景交互

总结

研究团队提出了一种用于物理可交互场景生成的引导条件扩散模型PhyScene。为了确保生成场景的物理合理性和可交互性,研究团队设计了新的引导模块,将物体碰撞、房间布局和可交互性约束转换为扩散过程中每个推理步骤中的引导。实验结果表明,在物理合理性和可交互性指标方面,PhyScene的效果优于以往的模型。证明了研究团队设计的物理引导模块和生成方法的有效性,这对于帮助智能体在交互环境中学习多样化技能具有巨大潜力,有望促进具身智能研究的进一步发展。

团队介绍

杨燕丹,通研院通用视觉实验室研究工程师,硕士毕业于北航,期间师从曹先彬教授。毕业后曾就职于腾讯。研究方向包括计算机视觉、具身智能等,发表多篇顶会论文。

贾宝雄,通研院通用视觉实验室研究员,博士毕业于美国加州大学洛杉矶分校,期间师从朱松纯教授并曾于Amazon Alexa AI实习,研究方向包括场景理解、行为理解、具身智能等,发表顶会论文二十余篇(CVPR,ECCV,ICV,NeurPS,ICLR,ICML,IROS)。曾组织多届国际会议研讨会、长期担任国际顶级期刊及会议审稿人,并曾获得CVPR及ICLR优秀审稿人奖。