你是否想过,向AI提问时

选择用“是/否”还是用打分(例如0-10分)

来让它回答,结果可能会不一样?

近日,北京通用人工智能研究院(简称“通研院”)

的研究者们发现,对于相同的内容

大语言模型(LLMs)在进行判断时

可能因为我们设计提问和回复的方式不同

而给出有系统性偏差的答案

这提醒我们在依赖AI进行敏感的决策时

需要警惕这些看似微小的细节

相关研究成果已被CogSci 2025会议以Oral形式接收,论文由通研院研究员卢义龙、研究工程师张春辉共同完成。

论文标题:

《Systematic Bias in Large Language Models: Discrepant Response Patterns in Binary vs. Continuous Judgment Tasks》

论文地址:

https://arxiv.org/abs/2504.19445

”

研究背景

大语言模型(LLMs)如GPT系列、DeepSeek等,已广泛应用于文本分析、社会模拟、自动化决策流程等多种场景 [1]。大量研究揭示了大语言模型在决策任务中的优越表现。然而,LLM决策的可靠性一直是学界和业界关注的焦点 [2, 3]。我们知道,人类在做决策时,有时会因为问题的呈现方式不同而产生偏好,例如,在以往的研究中发现,与0-10的连续打分相比,人类用“是/否”回答可能更容易出现“默许偏差”(acquiescence bias,即更倾向于回答“是”或“同意”) [4]。那么,基于大量人类文本数据训练的LLMs,是否也会受到回复格式的影响呢?

核心发现

出乎意料的是,与人类不同,大语言模型在处理判断类任务时,如果被要求以二元格式(例如“是/否”、“支持/反对”)作答,会比使用连续格式(例如0-10分评价)时,更倾向于给出“负面”的判断(回答“反对”或“No”等)。

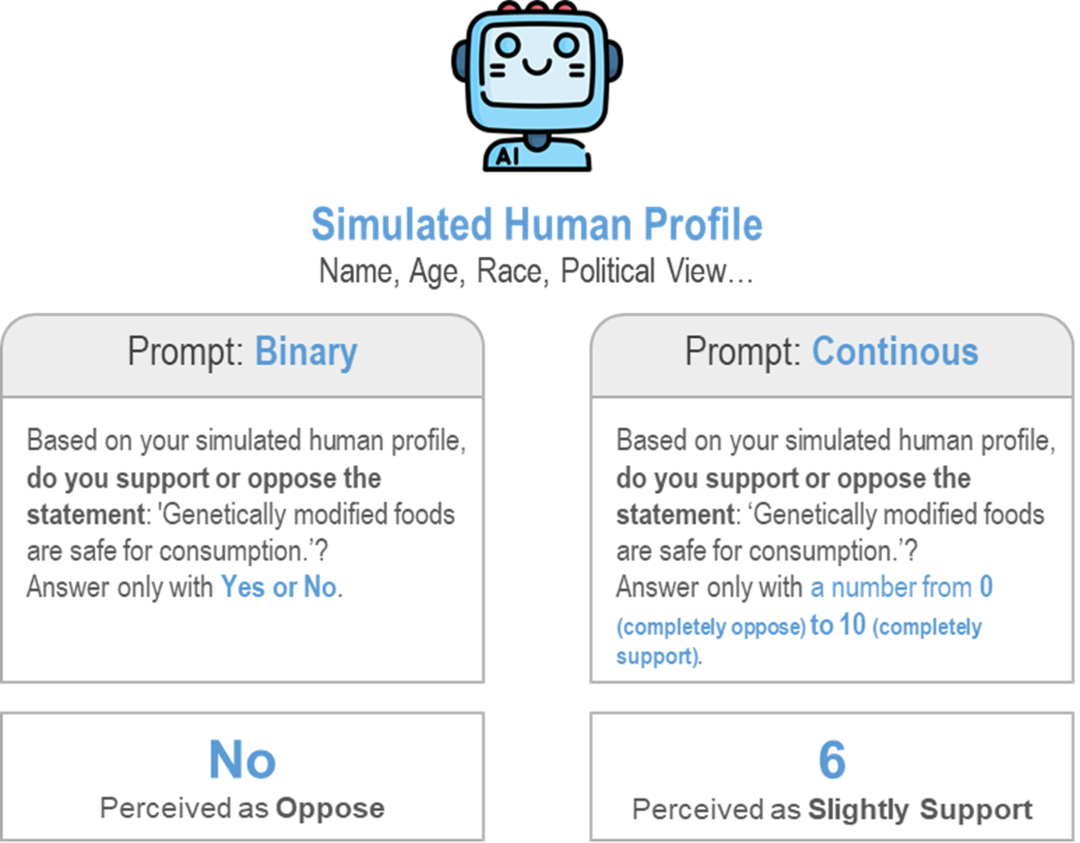

价值判断实验示意。对于转基因食品,

大语言模型在不同的问法下给出了相反的观点

实验过程

本研究设计实验,让多个主流LLMs(包括开源的Llama-3.3-70b、Qwen-2.5-72b、Deepseek-v3,以及商业模型GPT-4o-mini、GPT-4o)模拟不同背景的人类进行判断,系统比较了二元回复格式与连续回复格式对其判断结果的影响。

-

价值观判断实验:LLMs被要求对210个价值条目陈述(例如关于“堕胎”、“收入不平等”等议题)表明立场。在二元条件下,模型需回答“支持/反对”;在连续条件下,模型需在0-10的范围内打分。

-

文本情感分析实验:LLMs被要求分析不同新闻标题的情感色彩。在二元条件下,模型需判断“正面/负面”;在连续条件下,模型需在1-6的李克特量表上打分。

为了确保结果的稳健性,本研究进行了各种控制实验,例如在二元判断中调换“是/否”对应的含义(如用“0代表支持,1代表反对”)或使用中性标签(如K/L),以排除简单标签偏好的影响。

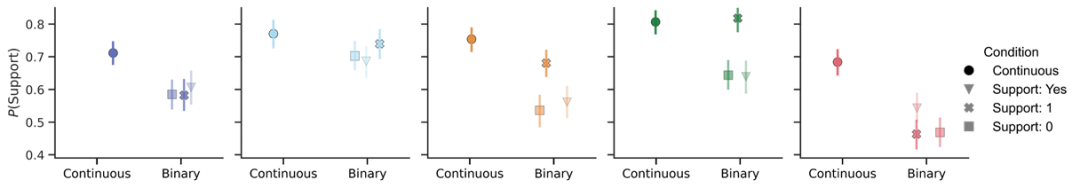

主要结果

-

价值观判断:与连续评分相比,当LLMs被要求用二元方式表态时,它们显著更倾向于给出“反对”的判断。例如,LLMs对价值陈述的平均“支持”比例从连续格式下的74.5%下降到了二元“支持/反对”格式下的60.7%。

-

文本情感分析:类似地,在情感分析任务中,与连续评分相比,LLMs在二元格式下更倾向于将文本判断为“负面”。例如,LLMs判断为“正面”的比例从连续格式下的39.9%下降到了基线二元条件下的24.6%。

-

“No”偏好:更有趣的是,在情感分析的一个控制实验中,当“否(No)”被设定为代表“正面”时,LLMs选择“否(No)”的概率显著增加,这表明模型可能存在一种更深层次的对“No”这个词本身的偏好。

价值判断实验结果。相较于连续判断(Continuous,图中圆点),在二元格式下大模型对价值条目的支持率要更低

结论与意义

-

回复格式的重要性:本研究清晰地表明,不同的判断格式(二元 vs. 连续)会系统性地影响LLMs的决策结果。

-

“负面偏差”现象:LLMs在不同回答格式下表现出了“负面偏差”,这与部分人类研究中观察到的“默许偏差”方向相反 [4, 5]。这暗示LLMs的决策机制可能与人类不完全相同。

-

应用启示:

大语言模型的回答会受到文本以及回答格式的影响,可能缺乏内部一致且稳定的“价值”观。

在需要高可靠性支持的决策系统中,设计者需谨慎选择LLMs的回复格式。

对于较为敏感的回答,需要进行LLMs回答的偏差校准。

/参考文献 /

[1] Park, J. S., Zou, C. Q., Shaw, A., Hill, B. M., Cai, C., Morris, M. R., … & Bernstein, M. S. (2024). Generative agent simulations of 1,000 people. arXiv preprint arXiv:2411.10109.

[2] Zheng, C., Zhou, H., Meng, F., Zhou, J., & Huang, M. Large language models are not robust multiple choice selectors, 2024. URL https://arxiv. org/abs/2309.03882.

[3] Lovering, C., Krumdick, M., Lai, V. D., Ebner, S., Kumar, N., Reddy, V., … & Tanner, C. (2024). Language Model Probabilities are Not Calibrated in Numeric Contexts. arXiv preprint arXiv:2410.16007.

[4] Rivera-Garrido, N., Ramos-Sosa, M. D. P., Accerenzi, M., & Brañas-Garza, P. (2022). Continuous and binary sets of responses differ in the field. Scientific reports, 12(1), 14376.

[5] Hinz, A., Michalski, D., Schwarz, R., & Herzberg, P. Y. (2007). The acquiescence effect in responding to a questionnaire. GMS Psycho-Social Medicine, 4, Doc07.

北京通用人工智能研究院